¿Cuáles son las características principales de las imágenes obtenidas en la teledetección? Te lo explicamos en profundidad en este fragmento de texto, extraído de uno de los módulos del “Curso de técnicas de teledetección aplicadas a la Geología”

Configuración en teledetección

2.1. Orbitas de los satélites

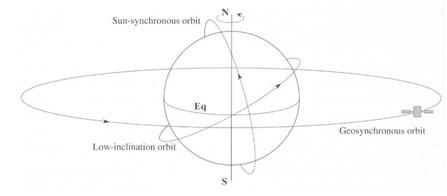

Un aspecto importante en la teledetección es la órbita de los satélites, entendida como la trayectoria que sigue el instrumento alrededor de la Tierra, ya que va a condicionar las características de los sensores y, por tanto, de los datos e imágenes para los que se han construido. Las órbitas quedan definidas por la altitud, orientación y rotación con respecto a la Tierra, y pueden ser órbitas geoestacionarias y órbitas heliosíncronas (Figura 19).

Un satélite con órbita geoestacionaria es aquel en el que el satélite permanece en una posición fija con respecto a la Tierra porque su periodo orbital es igual al periodo de rotación sidéreo de la Tierra, (23 horas, 56 minutos y 4,09 segundos) al moverse a una velocidad angular igual al de la rotación terrestre. Se sitúan en el plano ecuatorial terrestre, a 35.786 km con una excentricidad nula (órbita circular) y un movimiento de oeste a este. Con ésta configuración, el satélite siempre obtiene imágenes de la misma zona de la Tierra. Existe una red mundial de satélites meteorológicos geoestacionarios que proporcionan imágenes del espectro visible e infrarrojo de la superficie y atmósfera de la Tierra. Entre estos satélites se incluyen:

– Geostationary Operational Environmental Satellite (GOES), de Estados Unidos.

– Meteosat, de la Agencia Espacial Europea.

– GMS, de Japón.

– INSAT, de la India.

Sin embargo, la mayor parte de los satélites de teledetección siguen una órbita heliosíncrona de norte a sur con una ligera inclinación con respecto a los polos y sincronizada con la rotación de la Tierra (de oeste a este) para obtener imágenes de la mayor parte de la superficie terrestre. La denominación de heliosíncrona, se debe al hecho de que éstos satélites cubren la misma área del mundo, a una hora local fija del día, llamada hora solar local. Para una posición dada, el satélite pasa, exactamente a la misma hora local durante todo el año y la posición del Sol es aproximadamente la misma, de tal modo que todas las imágenes se obtienen con las mismas condiciones de iluminación para facilitar el estudio de imágenes de diferentes fechas. En las órbitas heliosíncronas, se denomina órbita ascendente cuando la plataforma se desplaza del hemisferio sur al hemisferio norte; y órbita descendente cuando el desplazamiento es del hemisferio norte al hemisferio sur. Dependiendo del tipo de sensor y la altura del satélite, el ancho de la franja que registra (denominado, ancho de banda) en una imagen o escena, puede variar desde decenas a cientos de kilómetros.

Estructura y características de las imágenes en teledetección

3.1. Estructura de las imágenes digitales

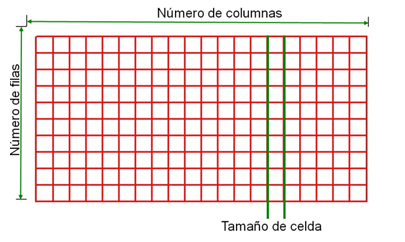

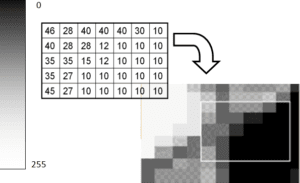

Las imágenes digitales se constituyen de unidades homogéneas en color denominadas pixel (acrónimo del inglés picture element, ‘elemento de imagen’). Cada pixel queda definido por su posición (fila, columna); el tamaño (mayor o menor resolución espacial) y luminancia (nivel de gris) (Figura 20).

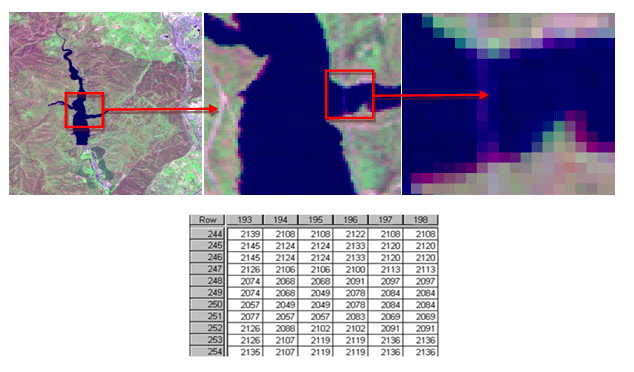

Esta imagen es discreta y finita ya que espacialmente tiene un número finito de celdas de tamaño determinado y en cuanto a su luminancia sus valores son enteros entre un mínimo y un máximo. En definitiva, una imagen digital es la adaptación al sistema informático de la imagen discreta en el que se procede a la asignación de un nivel de gris a cada elemento de imagen (píxel) a través de un nivel digital (ND), tal y como se muestra en la Figura 21.

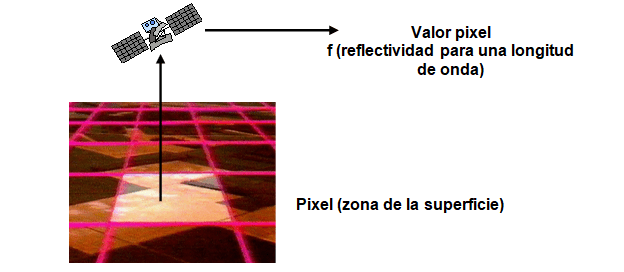

En las imágenes de satélite, la posición de cada uno de estos píxeles queda referida también por coordenadas de los puntos sobre el terreno (centro o esquinas de los pixeles). El tamaño o resolución espacial se refiere a la de la porción del terreno observada y la luminancia depende del ND de cada pixel que a su vez es función de la radiancia recibida desde cada porción del terreno (Figura 22). En la imagen de satélite se visualiza la información registrada en los detectores del sensor en una distribución bidimensional de energía E-M que es la respuesta de una superficie a la iluminación con energía E-M. La luminancia tiene una dependencia espacial, es decir, la intensidad luminosa es diferente en cada punto de la superficie iluminada. Una imagen discreta es aquella formada por un conjunto finito de valores de luminancia, obtenidos mediante el muestreo equi-espaciado de una imagen continua.

3.2. Bandas de las imágenes de satélites

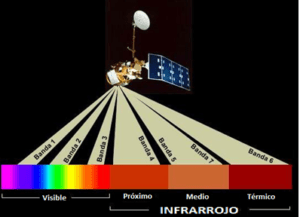

Los sensores recogen información en diferentes longitudes de onda y generan una imagen independiente que se denominan banda. Los sensores que sólo tienen una banda se les denomina pancromáticos y los que recogen imágenes en más bandas se les denomina multiespectrales. Así, un sensor presenta tantas bandas como imágenes en diferentes regiones del espectro electromagnético (Figura 23).

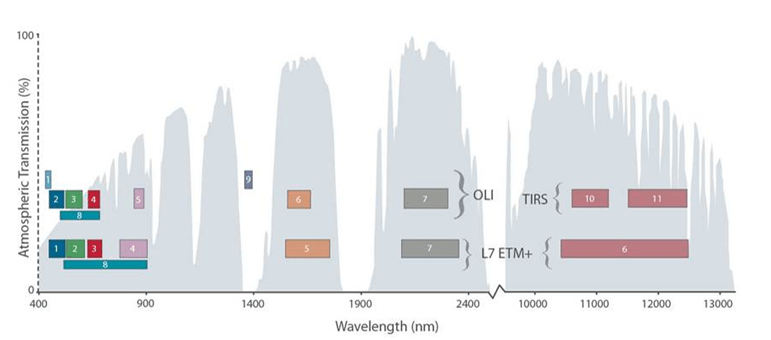

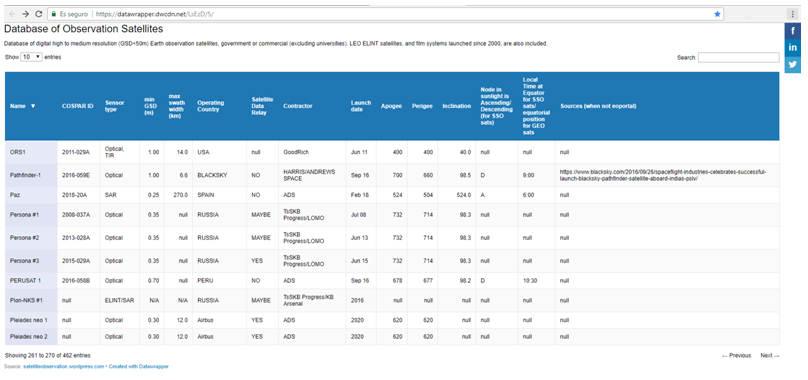

Cada sensor tiene un número específico de bandas que se sitúan en diferentes rangos de longitudes de onda (Figura 24).

En la figura 25 se muestra un ejemplo del número y localización espectral de cada una de las bandas de los sistemas Landsat 7 ETM+ y Landsat 8 OLI-TIRS operados por la NASA y de distribución gratuita.

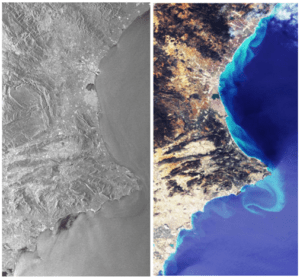

3.3. Visualización de las imágenes de satélites

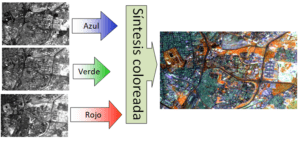

Los bits de una imagen proporcionan la capacidad de discriminar entre distintas magnitudes de intensidad de la energía incidente en el sensor. Los píxeles de cada una de las bandas tienen asignado un byte (8 bits) que corresponde a 256 posibles valores o ND. Para visualizar cada una de las bandas por separado, se le aplica una paleta de grises de tal modo que al mínimo valor (0) se le asigna el color negro; al máximo valor (255) de la imagen el color blanco y al resto de valores intermedios los correspondientes grises generando una imagen monocromática de grises denominada pancromática (Figura 26).

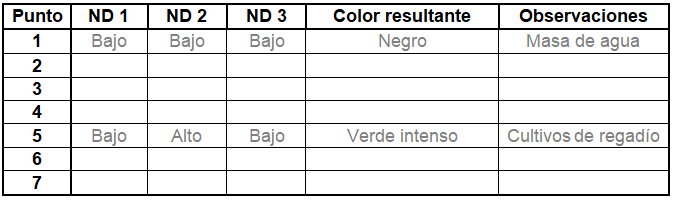

Cuando se quiere realzar las diferencias entre ND próximos se aplica color sobre una imagen monobanda (imagen coloreada). Las composiciones en color se utilizan para composiciones de bandas o bien para imágenes clasificadas en los que se diferencian unas cubiertas de otras de forma cualitativa. Pero lo más común es visualizar una imagen multibanda compuesta de tres bandas mediante el sistema RGB (colores aditivos primarios) que combinan luces de colores con unas longitudes de onda dadas: Rojo (R), Verde (G) y Azul (B), para obtener todos los demás colores (Figura 27).

Con éste sistema de visualización, asignamos cada una de las tres bandas seleccionadas de una imagen de satélite a cada uno de los cañones de luz (RGB). Con éste sistema, si por ejemplo un píxel presenta un intenso color azul hay que interpretar que el valor del píxel de la banda que se ha escogido para visualizarlo en la banda azul es muy alto, mientras que en el resto de las bandas su valor es muy bajo o próximos a cero. Si, por ejemplo, otro píxel presenta un color próximo al blanco significa que el ND en las tres bandas es muy alto (Figura 28).

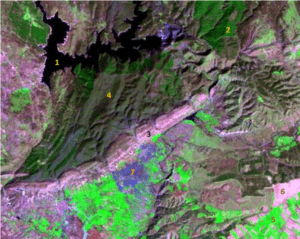

Para afianzar la interpretación de la visualización, realiza el siguiente ejercicio con la figura 29 compuesta por las bandas 5 (R), 4 (G), 2 (B) de una imagen Landsat 7. Para cada punto, indica el ND de cada banda (alto, medio o bajo) que consideras que pueden tener, en función de su color (utiliza como referencia la Figura 27).

Cuando se combinan bandas que corresponden a la banda de λ de los colores RGB, en el mismo orden se denomina combinación en color verdadero. Esto implica que en el cañón azul se visualiza la banda del sensor que recoge la radiación en la región espectral del azul, en el cañón verde se visualiza la banda del sensor que recoge la radiación en la región espectral del verde y en el cañón rojo se visualiza la banda del sensor que recoge la radiación en la región espectral del rojo. El resultado sería una imagen con el mismo color que podemos observar en la realidad.

Las composiciones en falso color son imágenes en las que las bandas se colocan en un orden distinto a la de los colores RGB. La elección de las bandas a utilizar depende del sensor que ha obtenido la imagen, si se quiere resaltar con un color determinado o una cubierta.

En el caso de Landsat 7 (bandas 1 a 7) se utilizan distintas combinaciones:

– 3-2-1. Color natural. Una aproximación a como veríamos la superficie terrestre desde el aire.

– 4-5-3 y 4-3-2. Falso color. La vegetación se traduce en colores rojos más intensos para masas forestales y regadío.

– 5-4-2 y 7-4-2. Pseudo falso color. La concentración de clorofila aparece en verdes. Buenas aplicaciones edáficas y geológicas.

– 5-3-2 y 5-2-1. Infraestructuras artificiales. Combinaciones para detectar infraestructuras artificiales que adoptan un color azulado.

3.4. Concepto de resolución en teledetección

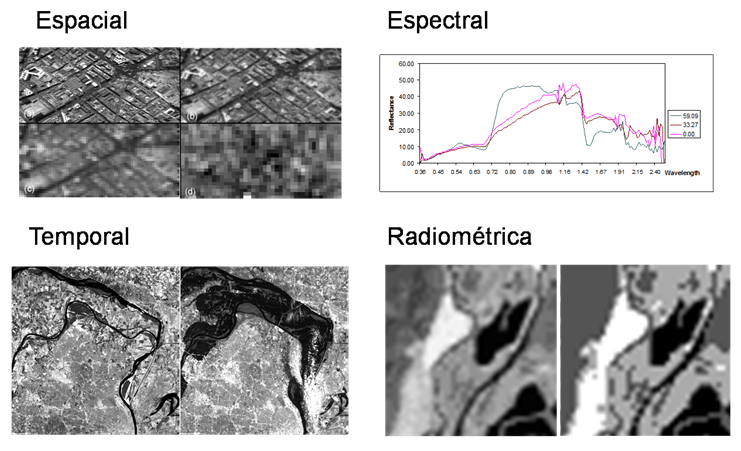

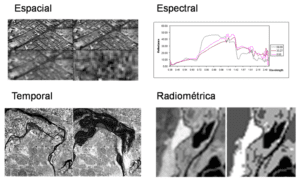

En teledetección se trabaja con cuatro tipos de resolución que son igualmente de importantes a la hora de determinar el tipo de imágenes que mejor se adecúa a los objetivos y metodología de un trabajo:

1) la resolución espacial o tamaño de píxel que hace referencia a la unidad de superficie real de la que se está tomando información.

2) la resolución temporal o tiempo que tarda el satélite en tomar dos imágenes del mismo sitito.

3) la resolución espectral que hace referencia a la capacidad de discriminar entre longitudes de onda vecinas en el espectro, así como al número de bandas disponible.

4) la resolución radiométrica o número de intervalos de intensidad que puede captar el sensor (Figura 30).

Lo ideal sería disponer de sensores con elevadas resoluciones en todos los aspectos, pero esto no es siempre posible. El aumento en la resolución implica un aumento en el volumen de datos y mejoras de los sistemas lo que dificulta las labores de tratamiento y clasificación que resultan muchos más complejas y un mayor precio. Existe una relación directa entre los diferentes tipos de resoluciones de un mismo sensor; por ejemplo, la resolución espacial es en gran medida opuesta a la temporal.

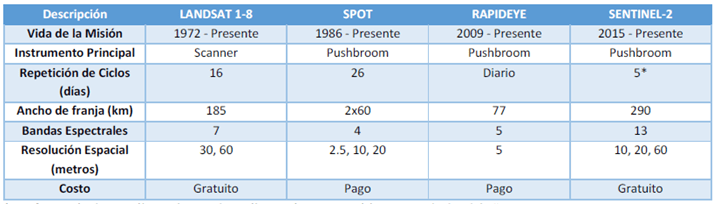

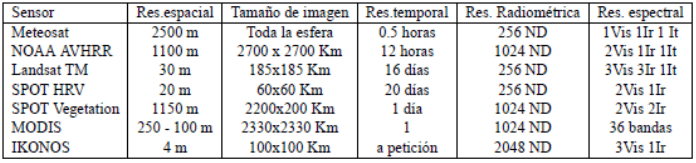

En la siguiente tabla (I) se muestran las diferentes resoluciones de algunos sensores.

En Database of Observation Satellites (https://datawrapper.dwcdn.net/LsEzD/5/) tenéis acceso a una base de datos de satélites de observación de la Tierra de resolución digital alta a media (GSD <50m). La base de datos registra el nombre de un satélite, su ID de COSPAR, tipo de sensor, resolución (la mejor disponible si hay varios sensores), ancho de franja (el más grande si hay varios disponibles), el país o compañía de operación, si puede enlace descendente sus datos en tiempo real a través de un satélite retransmisor de datos, el nombre del fabricante, la fecha de lanzamiento y las principales características orbitales (Figura 31).

3.5. Sistemas RADAR SAR

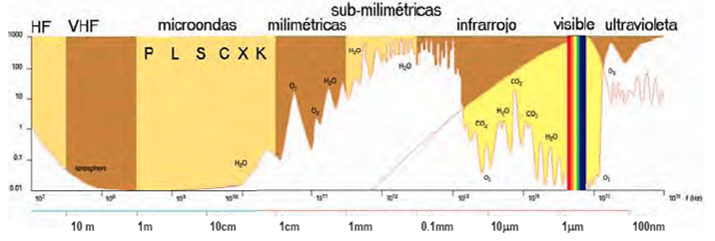

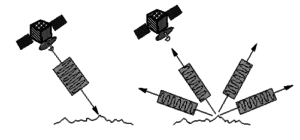

Los sensores activos de microondas (RADAR) emiten pulsos de energía de longitud de onda larga (de 1mm a 1m) a través de la atmósfera y luego registran la cantidad de energía retrodispersada desde el terreno En estas regiones del espectro, la absorción atmosférica es de muy baja a nula (Figura 32).

Existe un sistema específico Radar de Apertura Sintética (acrónimo SAR, del inglés Synthetic Aperture Radar) que consiste en procesar mediante algoritmos la información capturada por la antena del radar para conseguir mayores resoluciones. Este procesado busca combinar la información obtenida en varios barridos de la antena para recrear un solo “barrido virtual”. Al final el sistema radar proporciona el mismo rendimiento que daría si estuviese equipado con una antena mucho más grande y directiva que la que tiene en realidad.

Un radar activo emite un pulso de energía corto y direccional, después actúa como sensor y mide la energía de retorno o eco del radar (Figura 33). Los radares activos miden el tiempo-distancia, valor de retrodifusión y la fase del pulso que emiten. El valor de la señal recibida viene dado porque su intensidad es respuesta a las diferentes condiciones de su superficie (coeficiente dieléctrico, rugosidad y geometría).

La mayor parte de los radares de teledetección utilizan longitudes de onda que varían de 0,5 cm a 75 cm:

– Banda X: 2,4 a 3,75 cm (12,5 a 8 GHz). Uso militar y cartografía de terreno de elementos de detalle (SAR aeroportados), TERRASAR-X.

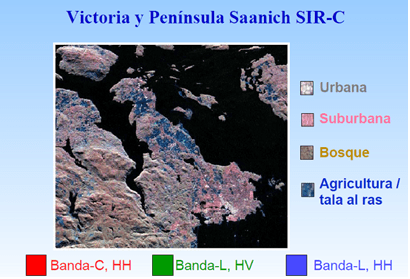

– Banda C: 3,75 a 7,5 cm (8 a 4Ghz). SAR espaciales con aplicaciones generales: Sentinel 1, ERS-1, RadarSat, SIR-C.

– Banda S: de 7,5 a 15 cm (4 a 2 Ghz). ALMAZ.

– Banda L: 15 a 30 cm (2 a 1 Ghz). Geología: SeaSat y JERS-1, SIR-C.

– Banda P: de 30 a 100 cm (1 a 0,3 GHz). Gran capacidad en la vegetación: AIRSAR de la NASA/JPL.

Las ventajas de los sistemas RADAR (Figura 34):

– Son transparentes a la nubosidad.

– Tienen capacidad de penetrar en el suelo, masas forestales y nieve.

– Como son sistemas activos funcionan en cualquier condición de iluminación (día y noche).

– Las condiciones de adquisición de datos pueden controlarse.

– Aportan información de la rugosidad del terreno, sus propiedades dieléctricas y contenido en humedad.

– Se pueden generar imágenes con diferentes configuraciones de polarización.

– La superposición estereoscópica de imágenes permite la radargrametría.

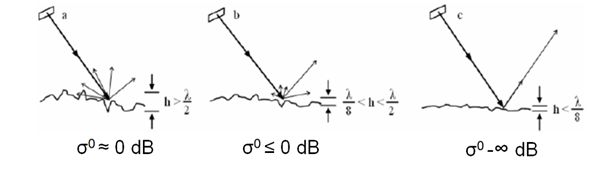

La señal RADAR que recibe el sensor depende de las características de la antena, la configuración de la imagen y de la retrodispersión (σ0) de los objetos que depende de la dimensión del objeto, de su morfología, de sus características dieléctricas, contenido de agua o humedad, y rugosidad. La retrodispersión se mide en la misma dirección que la onda incidente y por tanto dependerá del ángulo que ofrece la superficie.

La rugosidad de los objetos tiene alta incidencia en la señal de retorno y depende de la longitud de onda ya que define el modo de reflexión de la energía recibida. Para un mismo ángulo de incidencia tenemos: superficies rugosas, lambertianas y especulares (Figura 35).

Otras superficies se pueden comportar con fuerte señal de retorno por reflexión especular cuando la superficie es perpendicular a la incidencia de la radiación. Es el llamado efecto esquina de edificios y construcciones en zonas urbanas.

El aumento del ángulo de incidencia hace que el pulso de retorno sea menor. Incidencias normales en superficies especulares implican la reflexión total de la señal. En superficies rugosas sólo se recibe una parte de la emitida. Cuando la incidencia es superior a 15º en superficies especulares, no se produce señal de retorno, pero en superficies rugosas sí se produce una parte. Para ángulos muy elevados (>70º) es de esperar que el sensor no reciba señales de retorno ni siquiera en superficies rugosas (Figura 36).

Las condiciones dieléctricas vienen condicionadas por la presencia de agua en la vegetación o en el suelo que hace aumentar la señal de retorno. Las zonas con vegetación tienen mayor señal de retorno que los suelos secos (Figura 37). Pero las que presentan valores muy altos de retrodifusión son las superficies metálicas. La constante dieléctrica depende también de la frecuencia, textura y temperatura del suelo.

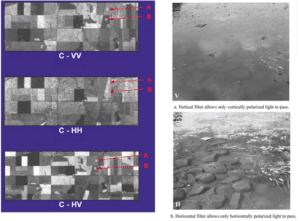

La polarización es la forma en la que se transmiten y reciben las señales radar, restringiéndose a una dirección determinada. Según se emita y reciba con la misma o distinta polarización, las dos formas de polarización más importantes son:

– Polarización semejante (HH o VV).

– Polarización cruzada (HV o VH).

La profundidad de penetración es mayor en configuraciones de polarización semejante (HH o VV) y mayor aún en las HH (Figura 38).

La multipolarimetría utiliza las imágenes que se generan simultáneamente en configuraciones de polarización diferentes (Figura 39). Constituye una herramienta muy útil para la interpretación visual y la clasificación ya que permite ayuda a distinguir la estructura física de las superficies:

– Alineamientos, estructuras en ángulo y aviones bajo el follaje (HH vs VV).

– Vegetación (HV).

– Océanos (VV).

– Efectos del viento (HV).

3.6. Principales sensores ópticos y térmicos

Existe un número importante de plataformas y programas que incorporan los sensores utilizados en teledetección que se pueden agrupar en diferentes categorías (Más detalles en el libro Satélites de Teledetección para la gestión del territorio: http://media.wix.com/ugd/1c299f_61722d445ea4b03dd776be74bb6f1513.pdf):

– Satélites meteorológicos de alta resolución temporal y baja resolución espacial.

– Satélites de observación de la Tierra con diferentes configuraciones de resolución.

– Satélites de alta resolución con muy alta resolución.

– Satélites hiperespectrales caracterizados por su alto número de bandas espectrales.

– Satélites RADAR (SAR) con sensores activos que trabajan en la región del microondas.

A continuación, se muestran los principales sistemas de satélites ordenados por resolución espacial (Figura 40).

Cuando se afronta un proyecto de teledetección hay que buscar las necesidades de resoluciones idóneas de los diferentes sistemas disponibles para la consecución de los objetivos marcados. En la tabla II se muestra una comparativa de algunos de las misiones más importantes (Tabla II).